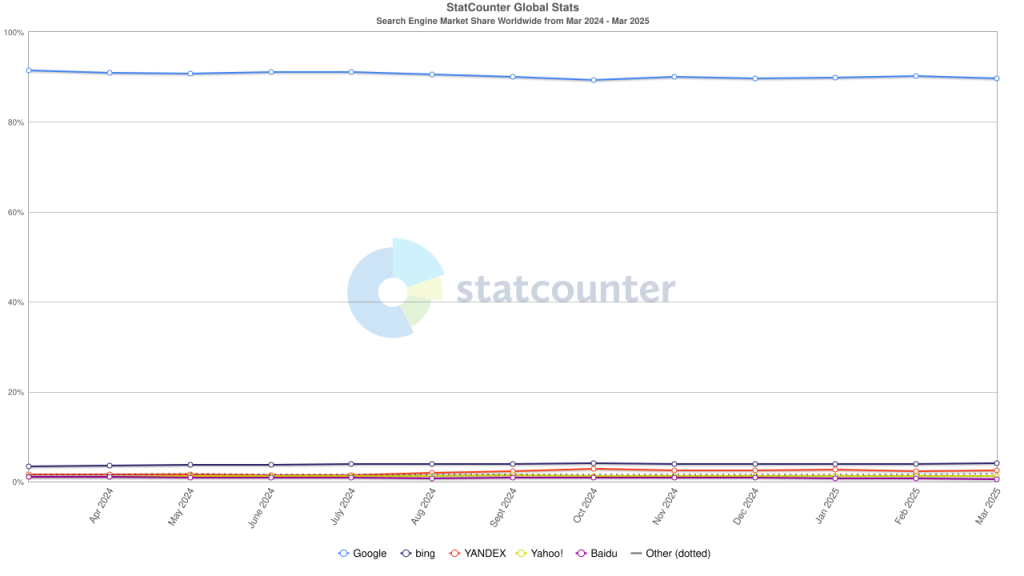

皆さんは、普段どのような検索エンジンを使っていますか。多くの人が、「Google」を思い浮かべたのではないでしょうか。筆者も利用しています。以下のグラフは、2024年3月から25年3月までの1年間における検索エンジンのシェア率を示したものです。ご覧の通り、約90%のユーザーがGoogleを使っていることが分かります。

画像出典:

Search Engine Market Share Worldwide | Statcounter Global Stats(最終閲覧:2025年4月21日)

https://gs.statcounter.com/search-engine-market-share

そんなGoogleは、24年5月に新機能「AI Overviews」を発表し、日本でも8月から利用できるようになりました。生成AI(Gemini)が、入力した検索ワードに基づいて独自の回答を生成し、検索結果の最上部に表示するというサービスです。複雑な情報源をもとに必要なポイントを短時間で把握できるため、ユーザー自身が適切な情報を一つずつ探し出す手間を省くことができます。

しかし、こうした利便性の裏には課題もあります。それは、「生成AIはハルシネーションを引き起こす可能性がある」という点です。ハルシネーションとは、AIが事実と異なる、あるいは誤解を招くような情報を生成してしまう現象を指します。

実際、私自身もAI Overviewsの表示内容と自分の記憶に食い違いがあり、複数のリンク先の情報や他の手段で確認したところ、AIが示した内容が事実とは異なっていたと分かった経験があります。世界で最も利用されているGoogleの検索結果に事実でない情報が堂々と表示されてしまうことで、ユーザーの認識が誤った方向に誘導される危険があるのです。

では、こうしたハルシネーションを完全になくすことはできるのでしょうか?

ハルシネーションが起こる理由は様々ですが、主に以下のような点が挙げられます。

・AIが学習する元データに不完全さや誤りがある

・ユーザーの検索内容を処理する過程で、文脈を誤って解釈する

こうした要因から、今後AI技術が進歩するにつれてハルシネーションの頻度や深刻さは徐々に減っていく可能性があります。一方で、現代は情報の増加スピードが非常に速く、それに追いつく形でAIが常に正確な判断を下すことは極めて難しいとも言えます。完全な対策を期待するのは現実的ではないかもしれません。

生成AIによる情報の要約は、私たちにとって非常に便利な道具でもあります。時間を節約しながら概要を掴みたいときには、強力なサポートツールとなるでしょう。だからこそ、ハルシネーションに惑わされずにAIと上手に付き合っていくために、「AIが誤った情報を出す可能性があることを常に意識する」ことが何より重要です。

参考記事:

4月16日付 朝日新聞朝刊 25面(社会)「AIで変わる検索市場 公取『競争の障壁』危惧」

参考資料:

AI による概要 : ウェブにつながる新しい方法|Google Japan Blog(最終閲覧:2025年4月21日)

https://blog.google/intl/ja-jp/products/explore-get-answers/ai-overviews/

AI ハルシネーションとは|Google Cloud(最終閲覧:2025年4月21日)

https://cloud.google.com/discover/what-are-ai-hallucinations?hl=ja

令和6年版情報通信白書(概要)|総務省(最終閲覧:2025年4月21日)

https://www.soumu.go.jp/johotsusintokei/whitepaper/ja/r06/summary/summary01.pdf